即可将网页分享至朋友圈

4月,计算机科学与工程学院计算智能团队,在人工智能领域权威期刊IEEE Transactions on Neural Networks and Learning Systems(TNNLS)、人工智能领域顶级学术会议International Joint Conference on Artificial Intelligence(IJCAI)、语音信号处理顶级会议IEEE International Conference on Acoustics, Speech, and Signal Processing(ICASSP)连续发表3篇类脑计算相关研究成果。

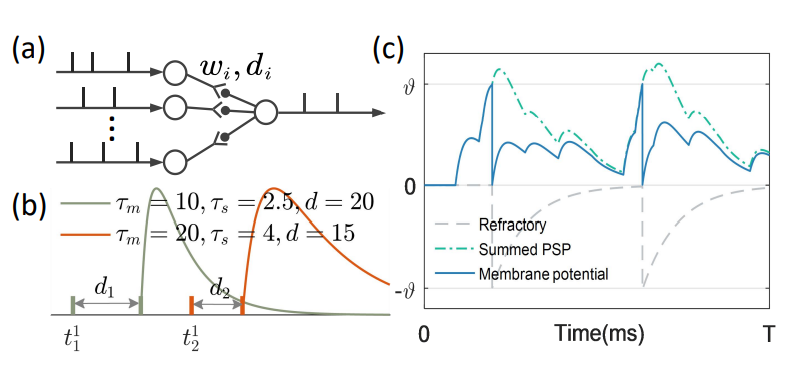

图1 带有可调节突触权重与延迟的脉冲神经元模型

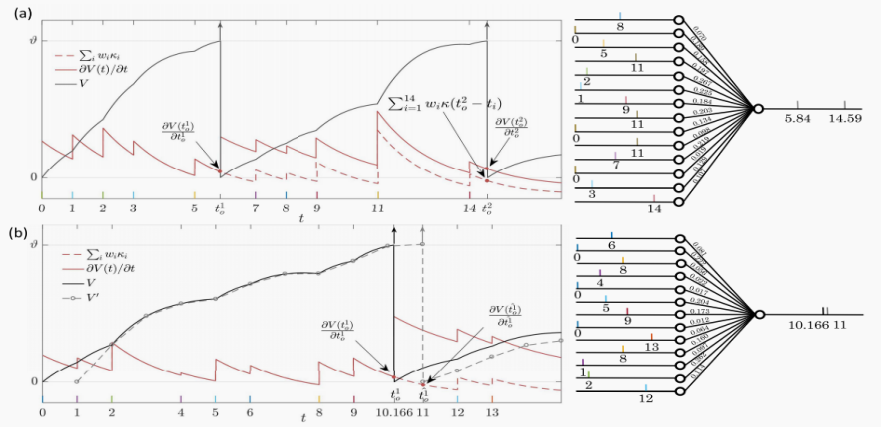

图2 脉冲点火梯度爆炸原因分析

研究成果《Supervised Learning in Multilayer Spiking Neural Networks With Spike Temporal Error Backpropagation》发表在人工智能领域权威期刊TNNLS上。罗笑玲为第一作者,电子科技大学屈鸿教授和张马路研究员为通讯作者,四川大学章毅教授为合作作者。

受脑启发的脉冲神经网络(SNNs)具有强大的计算能力及超低的芯片功耗,研究SNNs的高效学习算法对其理论发展及类脑芯片的片上学习都具有重要意义。但现有大多数算法仅针对突触权重进行调整,算法性能受限。受神经科学对生物突触延迟调节机制的研究结果启发,计算智能团队2017级博士研究生罗笑玲提出了一种同时调整突触权重与突触延迟的SNN学习算法(图1),验证了突触延迟在网络学习过程中发挥的重要作用。文中还对脉冲神经网络固有的脉冲点火不连续问题导致的梯度爆炸/消失问题作出分析(图2),并给出缓解策略。实验结果表明,该算法的学习效率和准确性与现有的脉冲时间算法相比有显著提高。

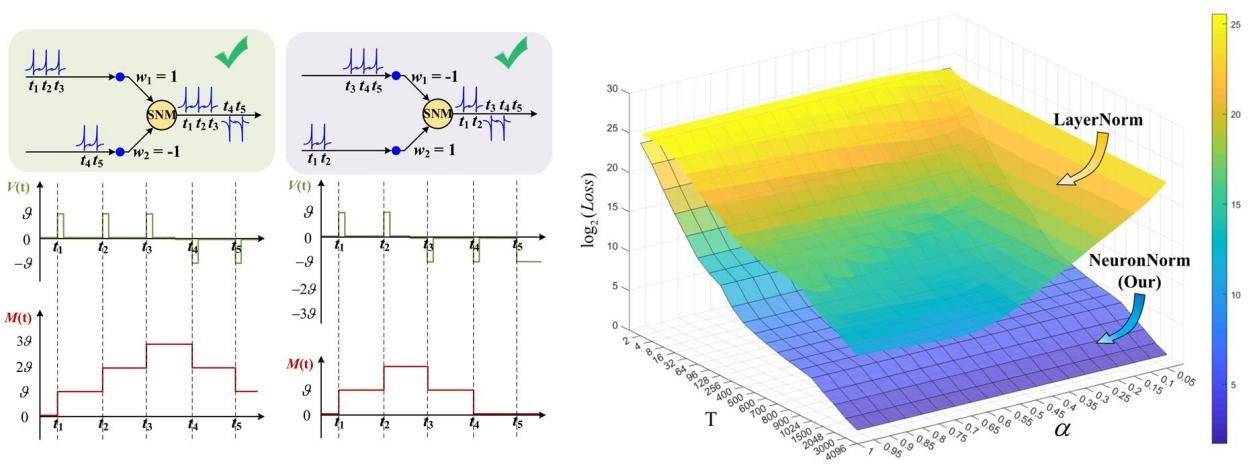

图3 SNM和Neuron-wise Normalization可以有效降低ANN到SNN的转换误差

研究成果《Signed Neuron with Memory: Towards Simple, Accurate and High-Efficient ANN-SNN Conversion》已被人工智能领域顶级学术会议IJCAI 2022接收。王语晨为第一作者,张马路研究员为第二作者,2018级陈一博士生为第三作者,通讯作者为屈鸿教授。

由于SNNs复杂的时间动态和脉冲的不连续性,直接训练SNNs通常存在计算资源高和训练时间长的问题。作为替代方案,可以从预训练的人工神经网络 (ANNs) 转换得到SNNs,从而绕过SNNs难以训练的问题。然而现有的ANN-SNN转换方法忽略了ANNs和SNNs在信息传输方面的差异。计算智能团队2021级博士研究生王语晨发现脉冲神经网络中异步传输的脉冲可能导致ANNs和SNNs之间发生转换错误,提出一种带记忆机制的有符号神经元(Signed Neuron with Memory,图3),在保持SNNs异步传输特性的同时保证异步传输的脉冲不会导致转换SNNs的精度损失;同时还提出了一种新的归一化方法——神经元尺度归一化(Neuron-wise Normalization),显著缩短了转换后的SNNs的推理延迟。功耗分析实验也证明了所提方法在达到ANNs准确率时只用ANNs网络推理所需能量的50.12%。

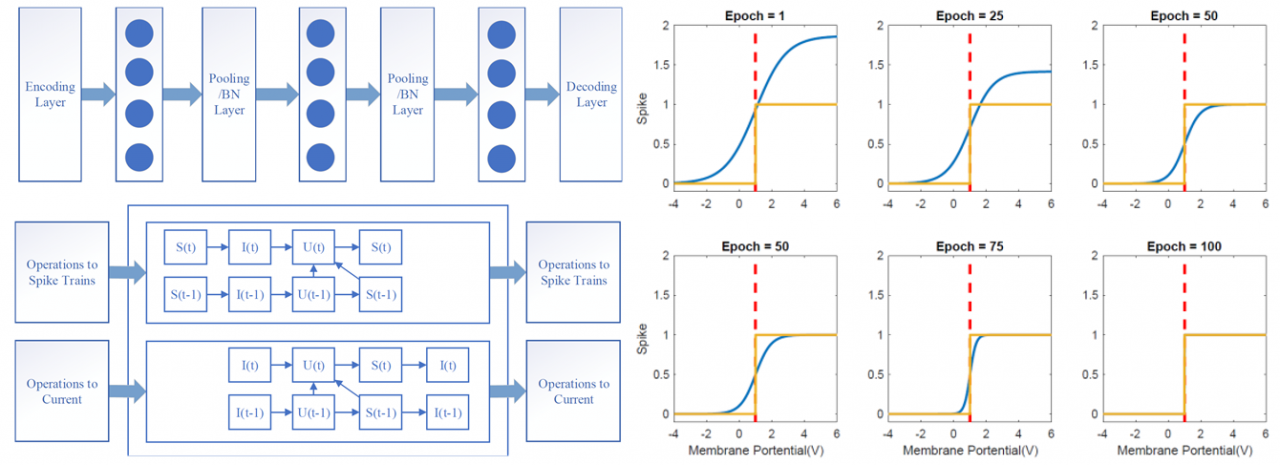

图4 内置脉冲神经元模型与渐进替换梯度算法

研究成果《Gradual Surrogate Gradient Learning in Deep Spiking Neural Networks》已被语音信号处理顶级会议ICASSP 2022接收。陈一为第一作者,2020级硕士研究生张司霖、任世雨为合作作者,通讯作者为屈鸿教授。

脉冲序列的离散性限制了ANNs中多种模块在SNNs的直接使用,同时需要人为选择脉冲编码解码策略,进一步增加了SNNs的设计难度。同时,在训练SNNs的动态过程中,不同阶段需要关注的侧重点不同。计算智能团队2018级博士研究生陈一为提出一种新的脉冲神经元建模角度与一种梯度自适应的学习算法,以提高脉冲神经网络训练效率。内置脉冲神经元模型将所有原本针对脉冲序列的操作转移到电流中,有效减少了信息正向传播过程中的损失。同时,所提出的梯度自适应算法在训练初期,有效促使尽可能多的神经元参与到学习过程中,在训练后期,要求神经元传回尽量准确的梯度信息,保证了脉冲神经网络中梯度回传的有效性和正确性(图4)。

上述多项类脑计算最新成果,针对脉冲神经网络特点,研究了适用范围更广的神经元模型与高效的训练算法,为类脑芯片的设计和实现奠定了坚实的模型和算法基础。

此外,团队2021级博士研究生曾鼎逸的研究工作《A Simple Graph Neural Network Via Layer Sniffer》(曾鼎逸为第一作者,通讯作者为电子科技大学计算机学院陈文宇教授)也被语音信号处理顶级会议ICASSP录用,文中提出了一种新的基于信息稠密程度的图神经网络层级信息融合算法,以提高图神经网络的性能以及可解释性。

王晓斌教授是电子科技大学计算智能团队的负责人,团队专注于人工智能、类脑计算、神经网络基础理论和应用的研究工作,在脉冲神经网络、图神经网络、强化学习等人工智能技术上取得了一批创新性的、高质量的成果。先后承担包括科技部重大专项、国家自然科学基金重点项目、各类省部级和企业横向项目40余项,获授权专利30余项,在人工智能领域顶级或知名期刊T-EVC、 T-CY、T-NNLS、PR、KNOSYS、 NEUNET、ASOC、J-STSP和国际顶级计算机会议 AAAI、IJCAI、ECAI、COLING、ICASSP等其他国际会议上发表论文150余篇,在人工智能等领域的研发与应用处于国内领先水平。

论文链接:https://doi.org/10.1109/TNNLS.2022.3164930

编辑:李文云 / 审核:林坤 / 发布:陈伟