即可将网页分享至朋友圈

近日,自动化工程学院2019级硕士研究生梁超的论文“Rethinking the Competition between Detection and ReID in MultiObject Tracking”在图像处理领域顶级期刊IEEE Transactions on Image Processing(TIP)上发表。梁超为该论文的第一作者,其导师周雪教授为通讯作者。

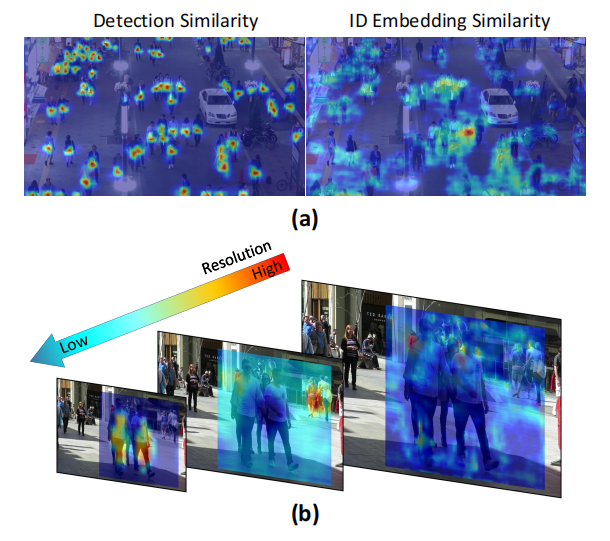

本次被录用的论文属于当前计算机视觉的研究热点之一——多目标跟踪。针对于当前一体化方法在跟踪性能方面与传统两阶段方法相比依然有较大差距的问题,本文分析其原因主要来自于一体化框架中检测和ReID任务之间存在竞争(如图1所示)。一个是语义表示的竞争,在检测任务中我们需要相同类目标(比如人体)都能学到相似的语义,而ReID则希望每个人体目标之间能学习到具有区分度的语义,两者存在本质矛盾。另一方面的竞争来自于目标分配的竞争,在检测中,通常会采用多分辨率特征输出的方式来构建模型,让不同分辨率的特征图关注不同尺度的目标,提高模型对目标的召回能力。然而这个结构并不适合于ReID,跨特征图的匹配会带来ID向量的对不齐问题,最终影响匹配结果。

图1 一体化方法中检测和ReID任务之间的竞争示意图

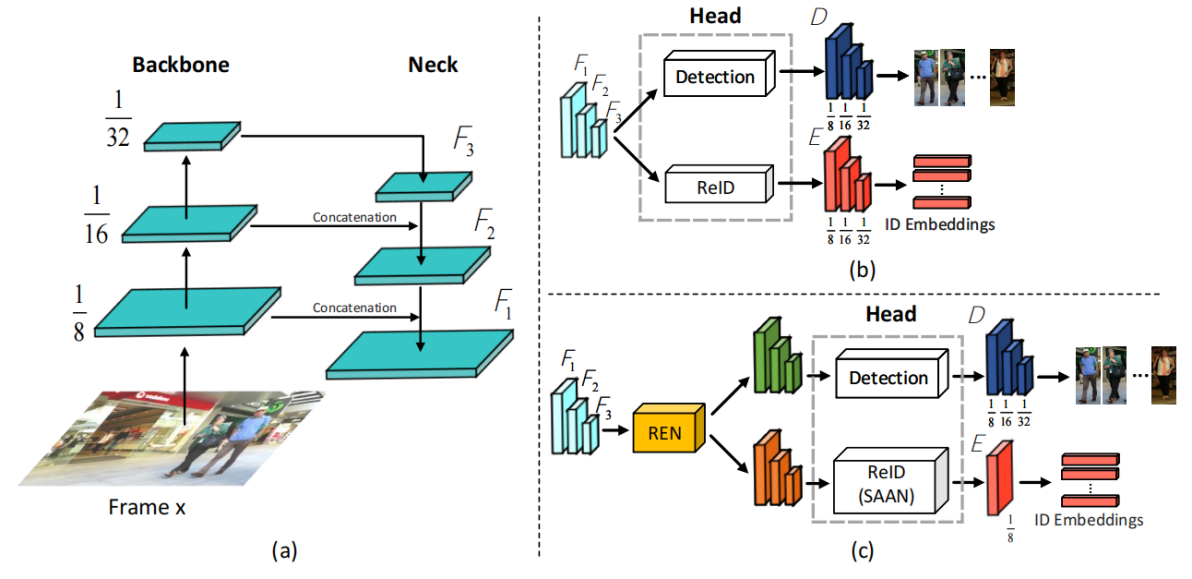

基于此,该论文的研究工作充分考虑了一体化跟踪器中检测和 ReID 这两个任务的本质差异,并针对性地设计了两个模块,即REN模块(Reciprocal Network)和SAAN模块(Scale-aware Attention Network),以提高一体化多目标跟踪方法中检测和ReID之间的任务协同。新提出的高性能一体化模型称之为CSTrack(如图2所示)。

图2 一体化多目标跟踪方法改进后的框架。(a)展示的是特征提取器(相同结构);(b)原有一体化方法(JDE)的输出网络设计;(c)为本文改进后的输出网络设计

REN模块从任务共性和特性学习的角度出发,通过特性和共性学习为每一个分支提供更有利于后续任务的特征表示,从而减少共享特征所带来的语义混淆。值得注意的是,该结构不仅有效地缓解了不同任务之间的有害竞争,而且提高了其互相协作学习的能力。而SAAN模块则是通过注意力机制增强了不同分辨率特征中与目标区分度学习相关的区域和通道的影响,并将其聚合为一个包含所有目标语义信息的统一输出。统一的匹配特征输出不仅有效消除了通过检测框架学习匹配信息所带来的不一致问题,同时提高了模型对目标尺度变化的弹性。

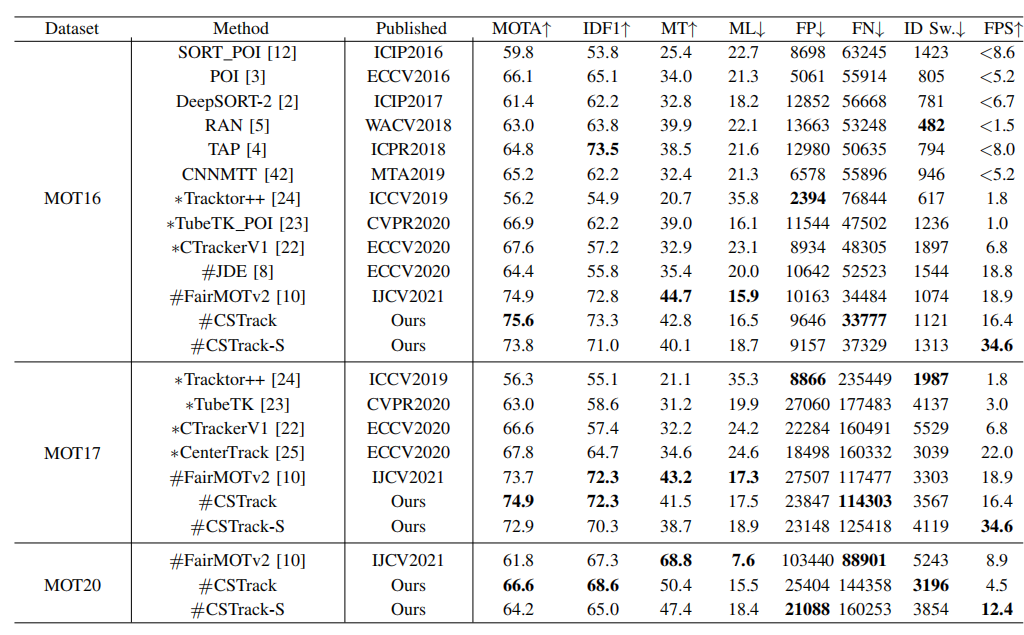

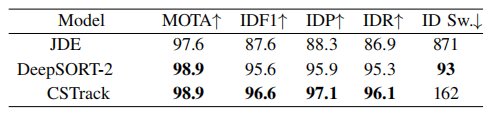

实验表明,上述两点改进能有效提高一体化方法的跟踪性能,尤其是在数据关联能力上带来大幅度地提升。从表1的实验结果来看,本文提出的方法在MOT Challenge的多个数据集上均取得了先进的跟踪性能。此外,为了减少不同检测结果所带来的影响,该研究工作也基于相同的检测(Groundtruth,GT)来评测学习出来的ID Embedding的数据关联能力。其结果如表2所示,相比于原有的一体化方法(JDE)和两阶段方法(DeepSort),CSTrack在数据关联能力分数(IDF1)上均取得了较大的提升。

表1. CSTrack在MOT16、MOT17和MOT20与近年来SOTA方法对比

表2 基于相同检测结果(Groundtruth,GT)下的方法比较

IEEE TIP是中科院SCI 1区期刊,也是中国计算机学会推荐的计算机图形学与多媒体领域A类期刊,影响因子10.856。被录用的论文主题涵盖了图像处理领域的各项前沿工作。

论文链接:https://ieeexplore.ieee.org/document/9756236

编辑:林坤 / 审核:林坤 / 发布:陈伟