即可将网页分享至朋友圈

近日,生命科学与技术学院neuSCAN团队连续在计算机科学领域国际著名期刊Information Fusion和美国电气和电子工程师协会人工智能及机器学习领域国际著名期刊IEEE Transactions on Neural Networks and Learning Systems(IEEE TNNLS)发表研究成果。

在Information Fusion发表的成果题为Instruction-ViT: Multi-Modal Prompts for Instruction Learning in Vision Transformer(指令ViT:基于视觉Transformer的多模态提示指令学习)。团队2021级硕士研究生肖振祥为论文第一作者,蒋希研究员为论文通讯作者,电子科技大学为论文第一署名单位。该论文得到了国家自然科学基金等支持。

人类智力的一个关键特征是能够处理来自多种形式的信息。人工智能目前的发展趋势之一是通过各种方法来有效地处理、整合和利用多模态数据来解决实际问题。随着大语言模型的发展,提示和指令在增强模型的应用能力方面发挥了重要作用。近年来,提示相关的一些策略被应用到视觉模型中,并取得了显著的性能提升。然而,多模态提示(如文本或图像)能在多大程度上提高视觉模型中的下游任务性能尚未得到系统的研究。

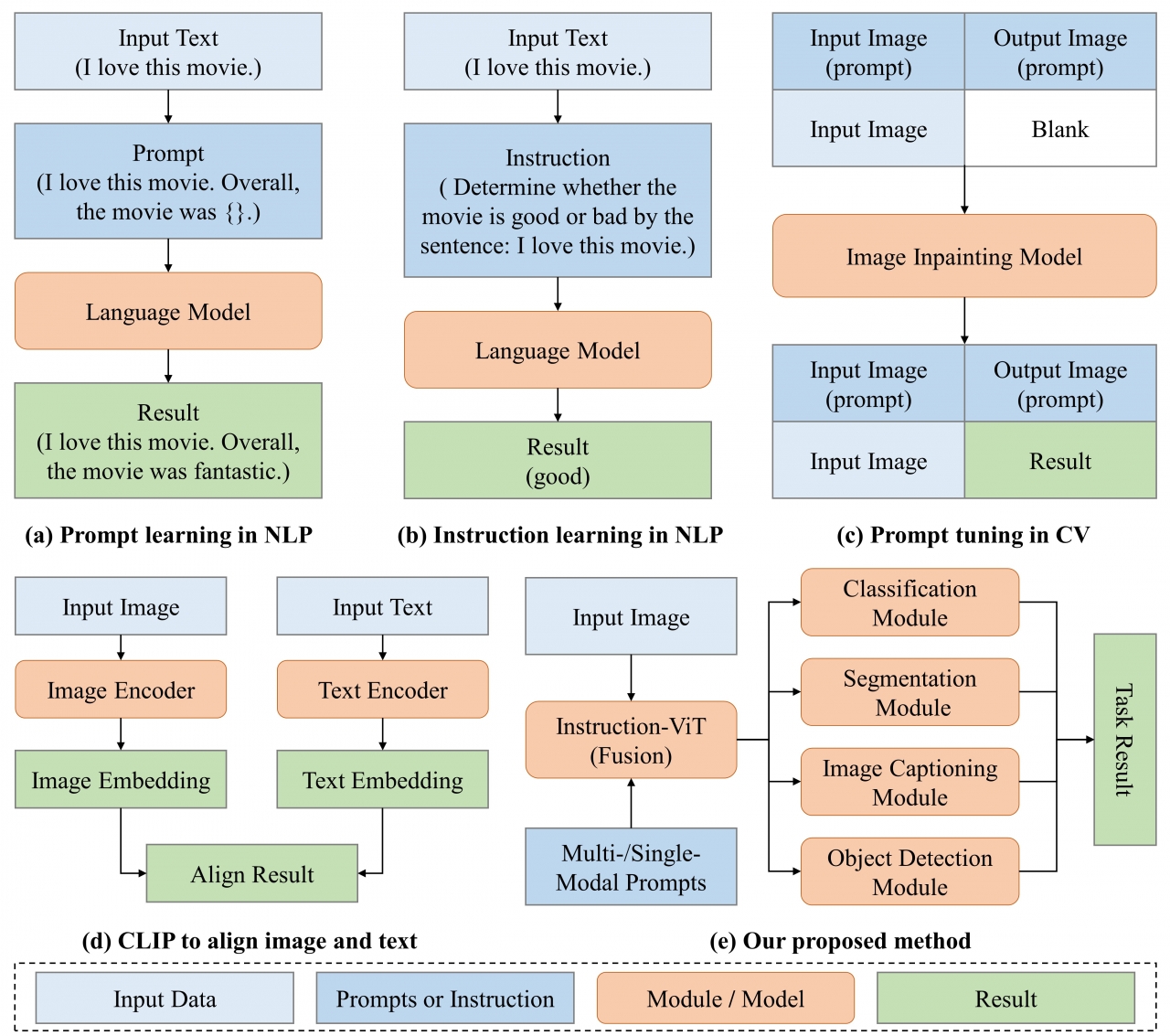

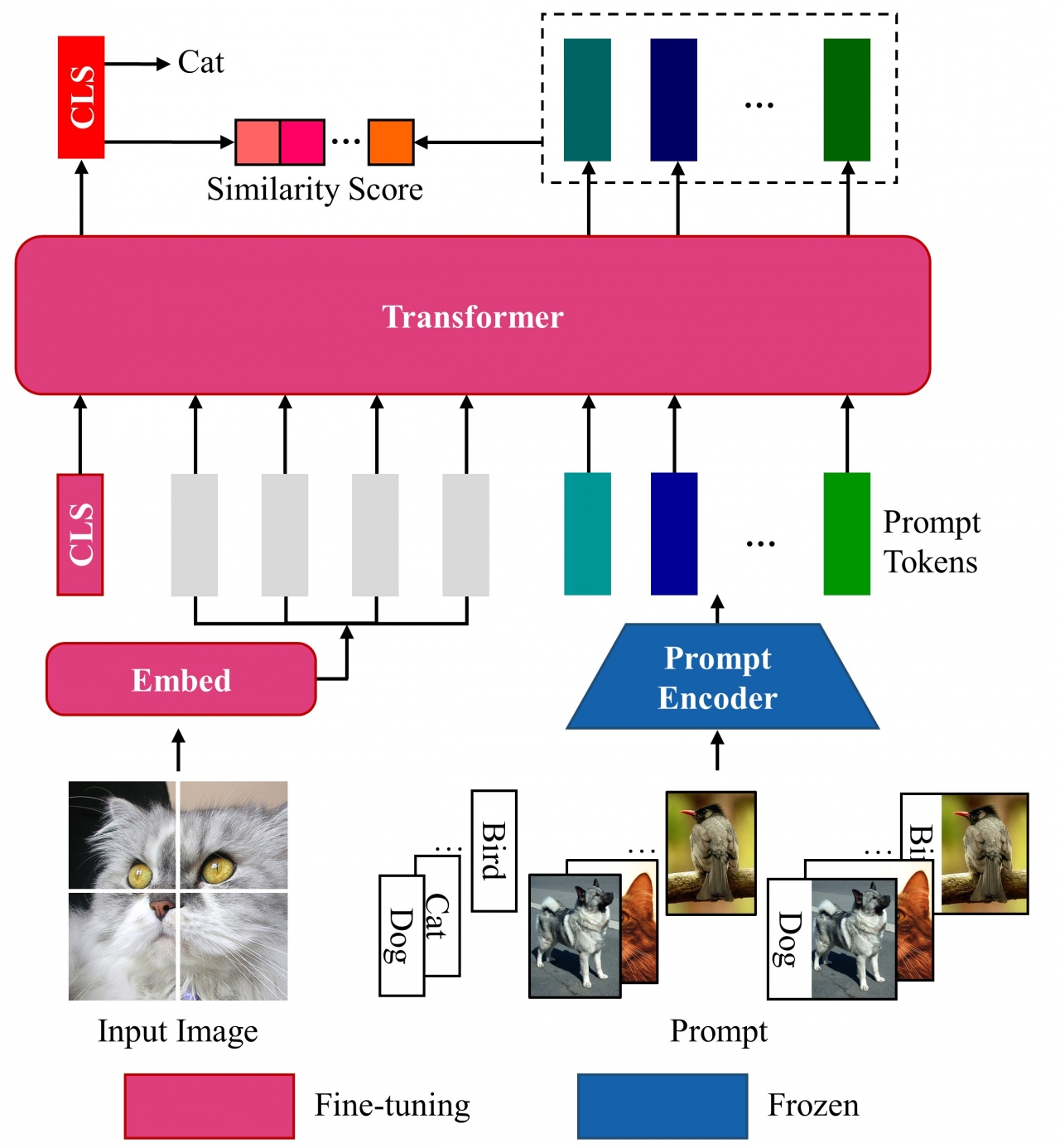

为了解决以上问题,本论文提出了基于指令调优的视觉Transformer(Instruction-ViT)。如图一所示,与其他方法相比,Instruction-ViT的关键思想是融合与类别信息相关的多模态提示(文本或图像),从而指导模型的微调并完成分类、分割、图像描述和目标检测等多个视觉任务。实验结果表明,Instruction-ViT的模型框架(图二)可以有效地使用单模态提示(如图像或文本)以及多模态提示(如图像和文本特征的融合),从而提升模型在下游任务上的性能。总体而言,该工作提出了一种融合多模态提示的创新策略,提高了视觉模型的性能和适应性。

图一 提出方法与其他方法的比较

图二 提出方法的流程示意图

Information Fusion为中国科学院大类一区top期刊,主要发表有关多传感器、多来源、多过程的信息融合领域的技术文章。CiteScore排名计算机科学大类硬件和框架子类所有期刊1/169,计算机科学大类信号处理子类所有期刊1/122,计算机科学大类软件子类所有期刊3/404,以及信息系统子类所有期刊3/379。

在IEEE TNNLS发表的成果题为A Unified and Biologically-Plausible Relational Graph Representation of Vision Transformers(一种基于视觉Transformer的统一且符合生物学的关系图表征方法)。团队2020级硕士研究生陈钰中为论文第一作者,蒋希研究员为论文通讯作者,电子科技大学为论文第一署名单位。该论文得到了国家自然科学基金等支持。

人脑是一个非常复杂且高效的非线性神经网络,人类的行为、认知和神经活动高度依赖于大脑连接组的图结构。同样,人工神经网络(ANN)的表示和预测能力,如卷积神经网络(CNN)等,也与模型的图结构密切相关。已有研究基于生物神经网络(BNN)与ANN有共同的图属性的假设,提出了关系图的概念,并探究了CNN网络的关系图结构如何影响其预测性能。近年来,得益于视觉Transformer(ViT)极佳的性能,各种不同的ViT在计算机视觉领域得到了迅速的发展。

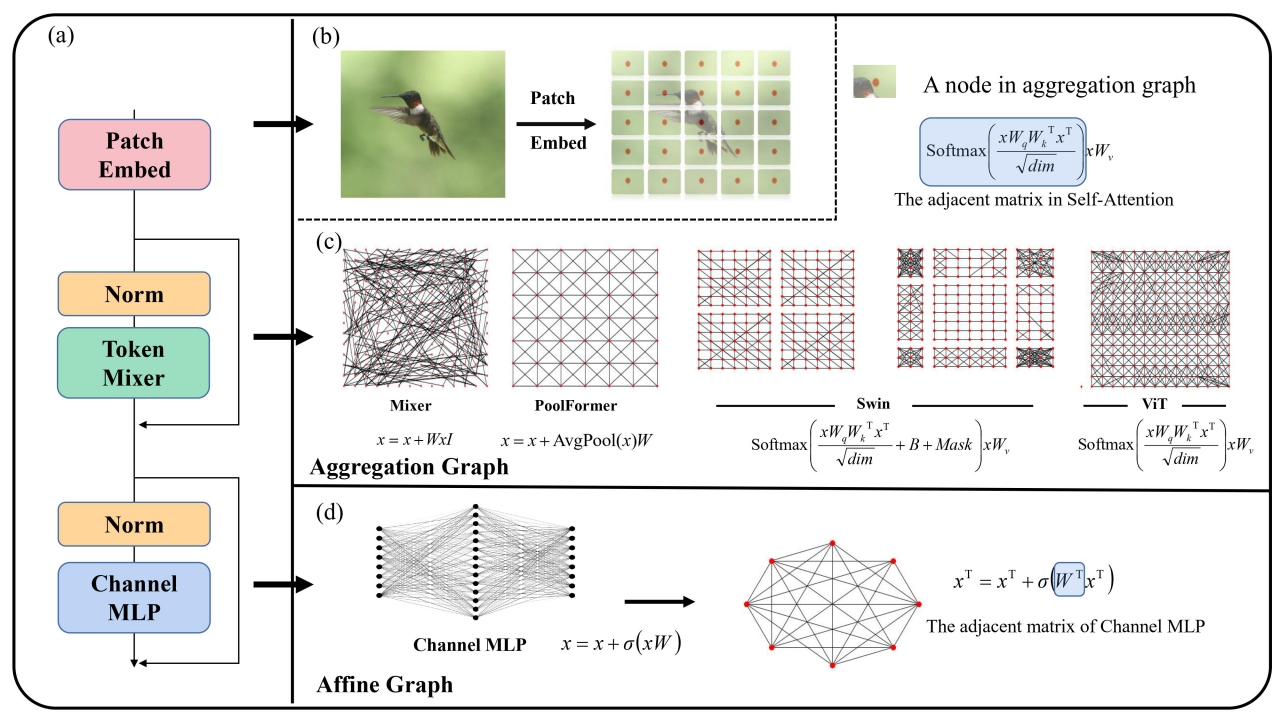

为了系统地探索ViT模型的优势,本工作探究了ViT的关系图结构与其预测性能之间的关系,以及ViT关系图结构与BNN的之间的关系。本工作的主要创新及贡献有以下四点:(1)本论文首次引入了一种新颖的、统一且符合生物学的ViT关系图表示方法;(2)在各种ViT模型的关系图上,本论文发现了图的度量指标的最佳点,包括聚类系数和平均路径长度。在这些最佳点上,ViT模型的预测性能显著提高;(3)为了进一步提高模型的性能,本论文提出了一种基于聚合图的损失算法;(4)本论文发现提出的ViT关系图表示与来自脑科学数据的真实BNN具有很高的相似性。

图三 不同ViT模型的聚合图和仿射图的构建方法

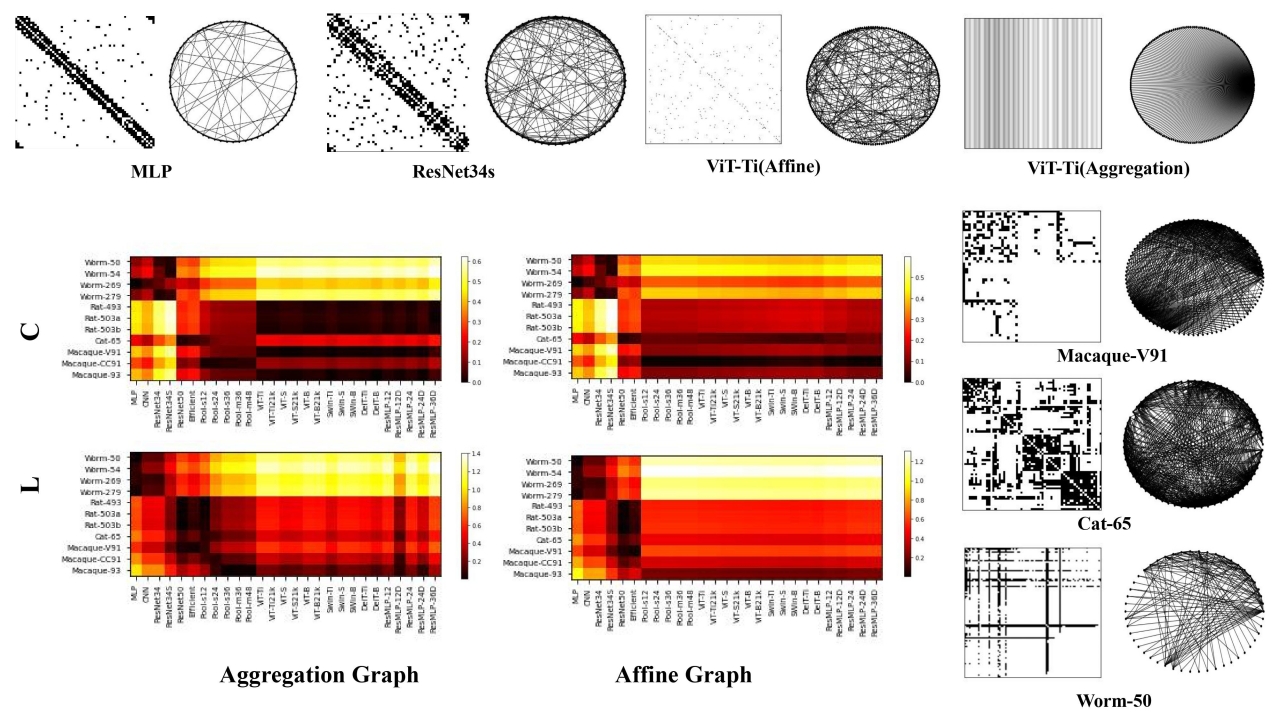

本文提出的ViT关系图表示方法如图三所示。通过将模型内的信息传递图分解为聚合图和仿射图,本文的方法可以应用于几乎所有具有代表性的视觉模型。本论文发现模型的性能和其关系图的属性如平均路径长度和聚类系数密切相关,尤其是在训练样本较少的情况之下。另外,文中所提出的ViT关系图与来自脑科学数据的真实BNN在聚合图和仿射图的平均路径长度和聚类系数之上具有很高的相似性,如图四所示。最后,文中还提出了一种基于图的损失算法来进一步提高模型的性能。总的来说,本文提供了一种可解释和有效的方法来分析ViT模型,并将模型的关系图与BNN联系起来,为人工神经网络的设计提供了新的见解。

图四 视觉模型与神经网络之间关系图的相似性,L:平均路径长度,C:聚类系数

IEEE Transactions on Neural Networks and Learning Systems为中国科学院大类一区top期刊,主要发表有关神经网络和相关学习系统的理论、设计和应用的技术文章。CiteScore排名计算机科学大类计算机科学应用子类所有期刊8/792,计算机科学大类计算机网络与通信子类所有期刊5/379,计算机科学大类软件子类所有期刊11/404,以及人工智能子类所有期刊10/301。

蒋希研究员是电子科技大学“百人计划”入选者,四川省学术和技术带头人后备人选。研究方向为神经影像计算和类脑人工智能。2019年“美国李氏基金会杰出成就奖之学术发展奖”唯一获奖者。曾获2021年医学影像分析国际会议MLMI最佳论文奖、2016年国家优秀自费留学生奖等荣誉。担任医学影像分析顶级会议MICCAI 2022-23年领域主席及多个国际期刊编委。共发表第一或通讯作者(含共同)论文37篇,Google学术引用3470余次,h指数30,i10指数79,SCI他引1400次。主持2项国家自然科学基金面上项目和1项青年项目。

论文链接:

Instruction-ViT: Multi-Modal Prompts for Instruction Learning in Vision Transformer

https://www.sciencedirect.com/science/article/pii/S1566253523005201

A Unified and Biologically-Plausible Relational Graph Representation of Vision Transformers

编辑:李果 / 审核:李果 / 发布:陈伟