即可将网页分享至朋友圈

近日,我校生命科学与技术学院视觉认知与类脑计算团队在人工智能、模式识别、计算机视觉领域国际顶尖期刊《IEEE Transactions on Pattern Analysis and Machine Intelligence》(IEEE T-PAMI)发表题为“Weakly supervised Micro- and Macro-expression Spotting Based on Multi-level Consistency”的研究论文。团队博士生余旺旺为论文第一作者,李永杰教授和杨开富副研究员为共同通讯作者,所有作者的署名单位均为电子科技大学。该研究工作得到了科技创新2030-“脑科学与类脑研究”重大项目(即中国脑计划项目)、四川省自然科学基金等的资助。

面部表情作为非语言交流的关键方式之一,能够非自主或自主地映射人的情绪波动,并在瞬息间传递复杂信息。视频中的微表情与宏表情定位,作为情感分析的首要环节,旨在精确捕捉视频序列中面部表情的起始与终止帧,界定其时序区间,并区分微表情与宏表情,为后续情感识别、分析及交互提供坚实支撑。然而,当前微表情与宏表情定位面临多重挑战:微表情的非自主性导致数据采集成本高昂;其短暂、细微且局部化的特点,不仅考验标注可靠性,更推高了标注成本;加之光照、头部及脸部运动等因素,模型定位性能大打折扣,严重阻碍表情分析在交互场景的应用。

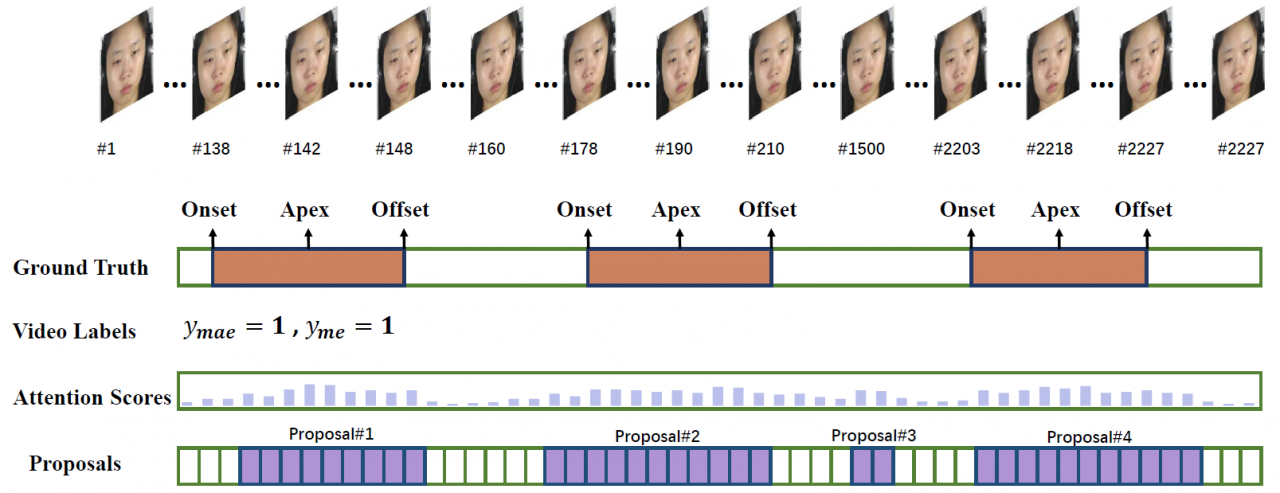

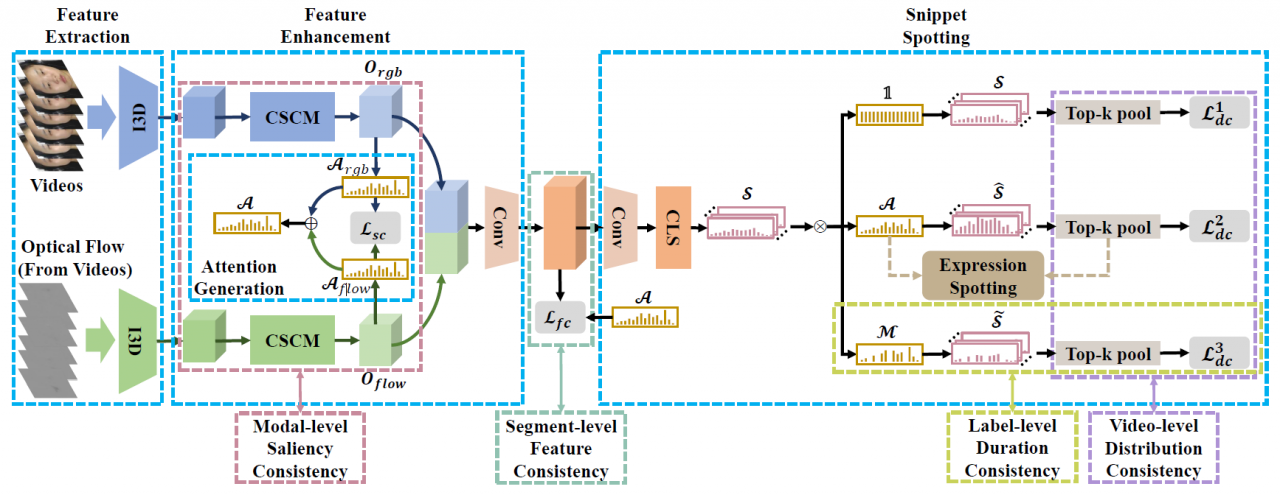

为了应对上述挑战,该工作提出了视频级弱监督(Video-level Weakly-supervised)学习策略,建立了仅依赖视频级(弱)标签的自动弱监督表情定位(Weakly-supervised Expression Spotting)方法。该方法仅依赖视频是否包含表情的粗粒度信息,彻底摒弃时序标注需求,可大幅降低标注难度(图1)。面对监督信息匮乏,该研究从多维度挖掘信息,提出多重一致性(Multi-level Consistency)协作机制,融合模态级显著、视频级分布、标签级时长及片段级特征等先验知识(图2),提升定位精度。实验证明,该方法通过有效利用粗粒度标签和多重先验,实现了细粒度帧级别表情的精确定位。

图1 该工作的建模思路

图2 该工作建立的模型架构

生命学院“视觉认知与类脑计算”团队依托于神经信息教育部重点实验室、科技部神经信息国际联合研究中心、四川省脑科学与类脑智能研究院等平台,长期致力于大脑视觉认知机理、视觉计算模型、类脑视觉技术与应用研究(包括全天候计算机视觉、智能医学影像分析等)。团队目前有教授2人、副高3人、助理研究员1人,博士后及在读硕博士生近40人。10多年来,先后承担973课题、脑计划项目课题、国家自然科学基金各级项目、各类省级项目等20余项,在重要期刊和会议发表论文200余篇,含神经科学类期刊(如NeuroImage、Human Brain Mapping等)、工程类期刊(如IEEE Transactions on PAMI/IP/MI/CSVT/ITS、IJCV、PR等)及国际顶级会议(如ICCV/CVPR/ECCV/ACMM等);申请中国发明专利60余项(其中已授权50余项),曾获吴文俊人工智能自然科学奖等。部分成果技术已在高铁线路巡检智能图像增强与损伤检测、医学图像组织分割与辅助诊断等工程问题中得到成功应用。

论文链接:https://ieeexplore.ieee.org/document/10979496

编辑:刘瑶 / 审核:李果 / 发布:陈伟