即可将网页分享至朋友圈

近日,自动化工程学院2022级硕士研究生方梓蒙的论文“Associate Everything Detected: Facilitating Tracking-by-Detection to the Unknown”在图像处理领域顶级期刊IEEE Transactions on Image Processing(TIP)上发表。方梓蒙为该论文的第一作者,其导师周雪教授为通讯作者。

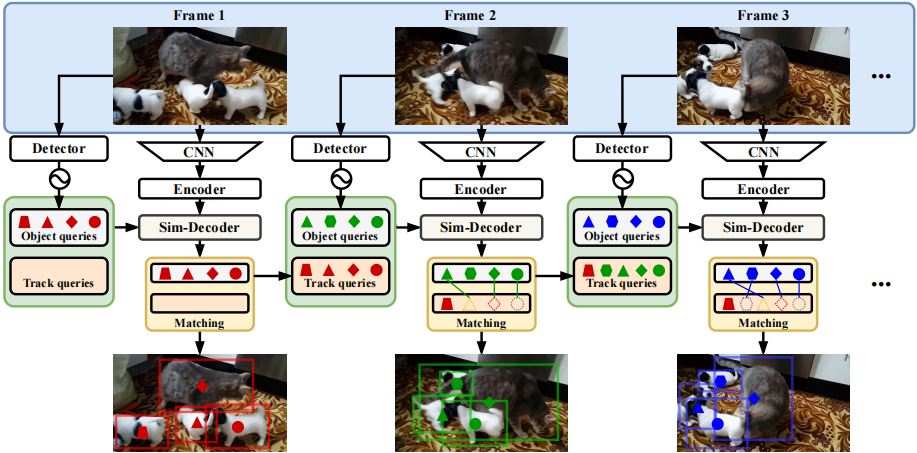

多目标跟踪(Multi-Object Tracking, MOT)是计算机视觉的核心研究方向之一,广泛应用于智能监控、自动驾驶等领域。传统封闭词汇(Closed-Vocabulary, CV-MOT)方法仅能跟踪预定义类别,而新兴的开放词汇(Open-Vocabulary, OV-MOT)方法虽可扩展至未知类别,但其性能在特定任务中仍落后于优化良好的CV-MOT方法。现有方法在CV-MOT和OV-MOT任务间难以兼顾,亟需一种统一框架解决这一矛盾。针对上述问题,本论文提出了一种全新的统一框架AED(Associate Everything Detected),通过“关联任意检测结果”的范式革新,实现了CV-MOT与OV-MOT任务的统一(如图1所示)。

图1 AED算法整体设计示意图

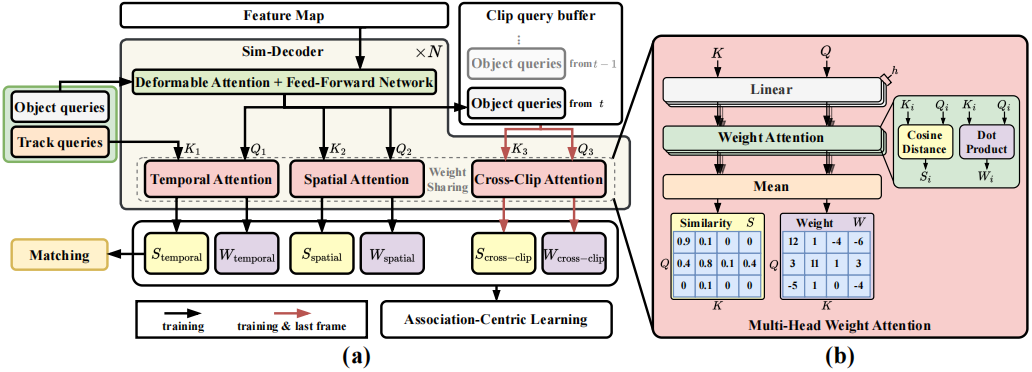

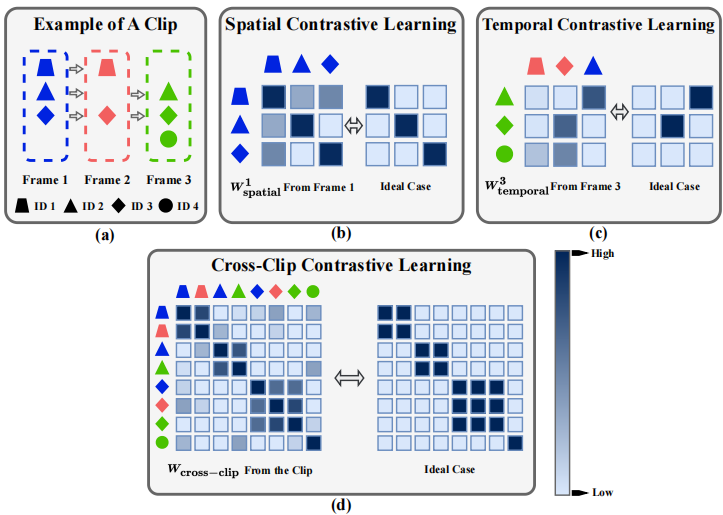

AED的核心创新在于设计了一个相似性解码器(Sim-Decoder)和以关联为中心的学习机制(Association-Centric Learning Mechanism)。如图2所示,Sim-Decoder通过多头权重注意力机制,动态计算检测框与历史轨迹间的时空相似性,无需依赖运动先验知识(如卡尔曼滤波),直接利用特征相似性完成数据关联。如图3所示,以关联为中心的学习机制则从空间、时序和多帧内三个维度设计对比学习策略,增强模型对目标身份的长期一致性建模能力。此外,AED兼容多种检测器(如RegionCLIP、Co-DETR),可直接关联任意类别(已知或未知)的检测结果,无需额外适配。

图2 相似度解码器示意图

图3 以关联为中心的学习策略示意图

本研究的主要贡献包括:提出首个统一CV-MOT与OV-MOT的跟踪框架AED,打破任务边界;设计以关联为中心的学习机制,实现特征表示与长时ID一致性的优化;在开放词汇和封闭词汇跟踪任务均取得较好性能。该成果不仅为多目标跟踪领域提供了理论突破,更在实际场景(如智能安防、赛事分析)中具有重要的应用价值。

IEEE Transactions on Image Processing(TIP)是中国科学院SCI一区期刊,中国计算机学会推荐的计算机图形学与多媒体领域A类期刊。该期刊涵盖了图像处理领域的前沿研究。

电子科技大学自动化研究所以电子信息技术为支撑,以人工智能及自动化技术为核心,主要从事智能装备的开发与应用,以及相关新理论、新技术的基础与应用研究。先后承担包括国家重点研发计划、国家自然科学基金等重大项目,获授权专利近百项,在人工智能、自控控制及电力电子顶级或知名期刊TIP、T-SMC、KBS、PR、NC、TPEL、TIE、JESTPE、TIA和国际顶级会议 ECCV、AAAI、IJCAI、ACC、CDC、ICASSP、IECON、APEC、ECCE等发表论文百余篇。周雪教授主要从事基于视频图像的目标检测、跟踪和识别的算法研究,同时也致力于攻关实际智能识别应用中的核心关键技术。

论文链接:https://ieeexplore.ieee.org/document/11105000

编辑:王晓刚 / 审核:李果 / 发布:陈伟